Tecnologia

Activa la “conducción autónoma” de su Tesla y el coche intenta medirse en un lago

Un vídeo, más de un millón de reproducciones y una pregunta incómoda para miles de conductores: ¿hasta qué punto se puede confiar en que un coche conduzca “solo”? Esta semana, un propietario de Tesla ha desatado la polémica tras asegurar que su vehículo, con la última versión del sistema de Conducción Autónoma Total (FSD), intentó medirse directamente en un lago.

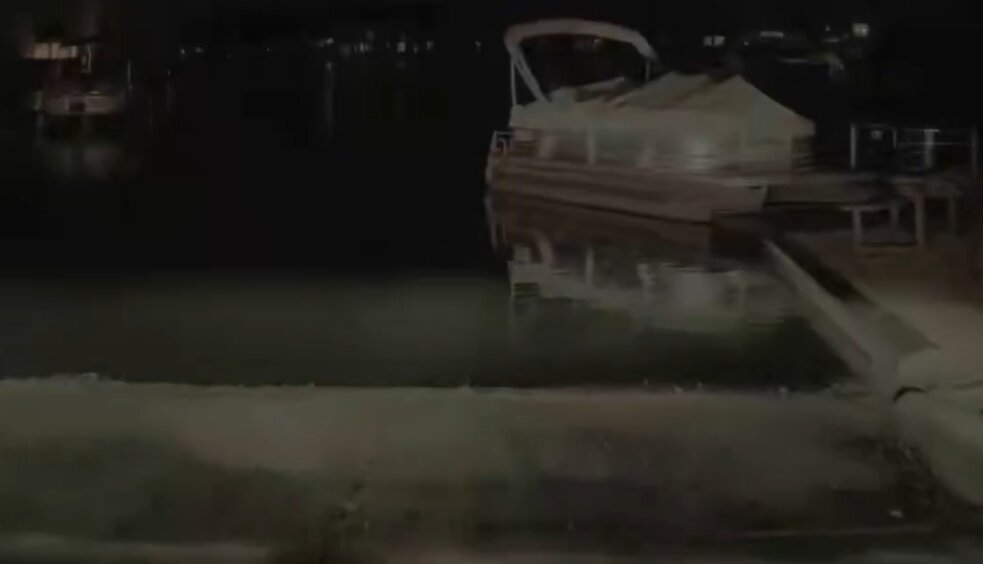

El director grabó la escena y la publicó en redes. En las imágenes se ve cómo el coche, circulando con la versión 14.2.2.4 del software, empieza a dirigirse hacia el agua sin aparente reconocimiento del peligro. Solo la rápida intervención humana evita el desenlace. Y ahí está la clave del asunto: tuvo que intervenir.

Porque, aunque su nombre pueda llevar a engaño, la llamada “Conducción Autónoma Total” sigue siendo un sistema de asistencia de nivel 2. Eso significa que el conductor no puede soltar el volante ni dejar de prestar atención en ningún momento. El coche ayuda, pero no se responsabiliza.

Un nombre que genera expectativas… y confusión.

El problema no es solo este fallo puntual. Todos los sistemas avanzados de ayuda a la conducción cometen errores. El debate real está en el mensaje que transmite el nombre del sistema. Para muchos usuarios, “Conducción Autónoma Total” suena a autonomía real. Para los reguladores, está muy lejos de serlo.

A esto se suma un detalle importante: Tesla cobra 99 dólares al mes por acceder a este sistema mediante suscripción. No es una función experimental gratuita, sino un servicio premium. Y cuando se paga cada mes por una tecnología que promete facilitar la conducción, el margen de error se vuelve mucho más difícil de aceptar.

Una lista de incidentes que sigue creciendo.

Este caso no está aislado. En los últimos meses se han documentado otros episodios con el FSD activado:

- Cambios de carril hacia tráfico en sentido contrario

- Maniobras extrañas en cruces

- Colisiones contra obstáculos visibles

En Estados Unidos, la NHTSA mantiene investigaciones abiertas sobre millones de vehículos Tesla, tras vincular decenas de incidentes al uso de Autopilot y FSD. Algunas pesquisas analizan comportamientos tan graves como saltarse semáforos en rojo o invadir carriles opuestos.

Tesla, por su parte, insiste en que su sistema es el más avanzado dentro de los asistentes de nivel 2. Y lo cierto es que, en muchas situaciones, ofrece una experiencia fluida y sorprendente. Pero cuando falla, la línea entre lo impresionante y lo peligroso es muy fina.

¿Un fallo aislado o una señal de alerta?

Es fácil convertir un vídeo viral en símbolo de todo un sistema. También es cierto que millones de kilómetros se recorren cada día con estas funciones activadas sin incidentes graves. Pero cada error llamativo vuelve a plantear la misma cuestión: ¿va el marketing por delante de la tecnología?

Tesla lleva años prometiendo una conducción completamente autónoma y sin supervisión. A día de hoy, esa promesa sigue sin cumplirse. Y el modelo por suscripción refuerza la sensación de que el sistema está en constante evolución, no que sea una capacidad cerrada y plenamente confiable.

El vídeo del coche acercándose peligrosamente al lago no es solo una anécdota viral. Es un recordatorio claro para cualquier director: por muy cómodo que sea el software, la última responsabilidad sigue siendo humana.