Eventos

evolución del sonido en los conciertos

De los altavoces de madera en Woodstock a los sistemas digitales de Coachella: medio siglo de ingeniería que cambió la forma de escuchar música en directo

En 1969, Woodstock se convirtió en un laboratorio improvisado para una industria que aún no sabía cómo amplificar una multitud. Medio millón de personas y apenas veinte amplificadores McIntosh MC3500 alimentando un puñado de altavoces JBL y Altec Lansing sobre torres de madera. Aquella infraestructura precaria definió los límites físicos del sonido en vivo, y al mismo tiempo inauguró un nuevo estándar: el de la aspiración colectiva a escuchar música amplificada con la misma intensidad con la que se vivía.

Cinco décadas después, festivales como Coachella o Tomorrowland operan bajo otra lógica. El sonido ya no se proyecta; se diseña. Cada metro cuadrado de terreno está cubierto por algoritmos de predicción acústica, procesadores DSP y redes Dante que distribuyen cientos de señales en tiempo real. El público no “escucha” el concierto: habita dentro de una arquitectura sonora. La diferencia no está solo en la potencia, sino en el grado de control.

La evolución entre ambos extremos no es una simple mejora técnica, sino una transformación cultural. Lo que empezó como una batalla contra la distancia y la intemperie se ha convertido en una ciencia de precisión que busca experiencias inmersivas, reguladas y medibles. Este recorrido —de los altavoces de madera marina a los line arrays digitales— resume medio siglo de ingeniería aplicada al espectáculo y explica cómo el sonido pasó de ser un obstáculo a convertirse en el verdadero lenguaje de los festivales.

Woodstock 1969: El punto de partida

El sonido en Woodstock fue, más que una proeza técnica, un experimento a gran escala como dijimos más arriba. El ingeniero Bill Hanley, considerado el padre del audio de festivales, diseñó un sistema pensado para unas 200.000 personas. Terminó enfrentándose a más del doble. El reto no era amplificar música, sino intentar que casi medio millón de asistentes distinguiera algo más que ruido en un campo abierto sin precedentes logísticos. El resultado marcó el inicio de la ingeniería moderna del directo.

El sistema combinaba amplificadores McIntosh MC3500 —350 vatios cada uno— con cajas acústicas personalizadas que alojaban cuatro altavoces JBL D140 de 15 pulgadas. Se montaron en torres de más de veinte metros de altura para maximizar la dispersión. No existían los cálculos digitales ni los softwares de predicción; todo se ajustaba por intuición, oído y experiencia empírica. Lo que hoy se planifica con modelos acústicos tridimensionales entonces se resolvía con cinta adhesiva y paciencia.

Aquella precariedad reveló tanto los límites como las posibilidades del sonido amplificado. Por primera vez, se demostró que el sonido directo podía alcanzar distancias antes impensables sin degradación catastrófica. El público no lo sabía, pero estaba presenciando el nacimiento de un nuevo paradigma: la idea de que la ingeniería podía escalar la emoción colectiva de la música. En un sentido técnico, Woodstock no fue el mejor sonido posible; fue el primero que se atrevió a serlo.

JBL quedó inscrita en esa historia no como patrocinador ni como marca visible, sino como parte del esqueleto funcional del sistema. Los D140 soportaron el peso físico y simbólico de un evento que cambió la percepción de lo que podía ser un concierto al aire libre. Desde entonces, el sonido dejó de ser un accesorio del espectáculo para convertirse en su condición de posibilidad.

Años 70: Experimentación extrema

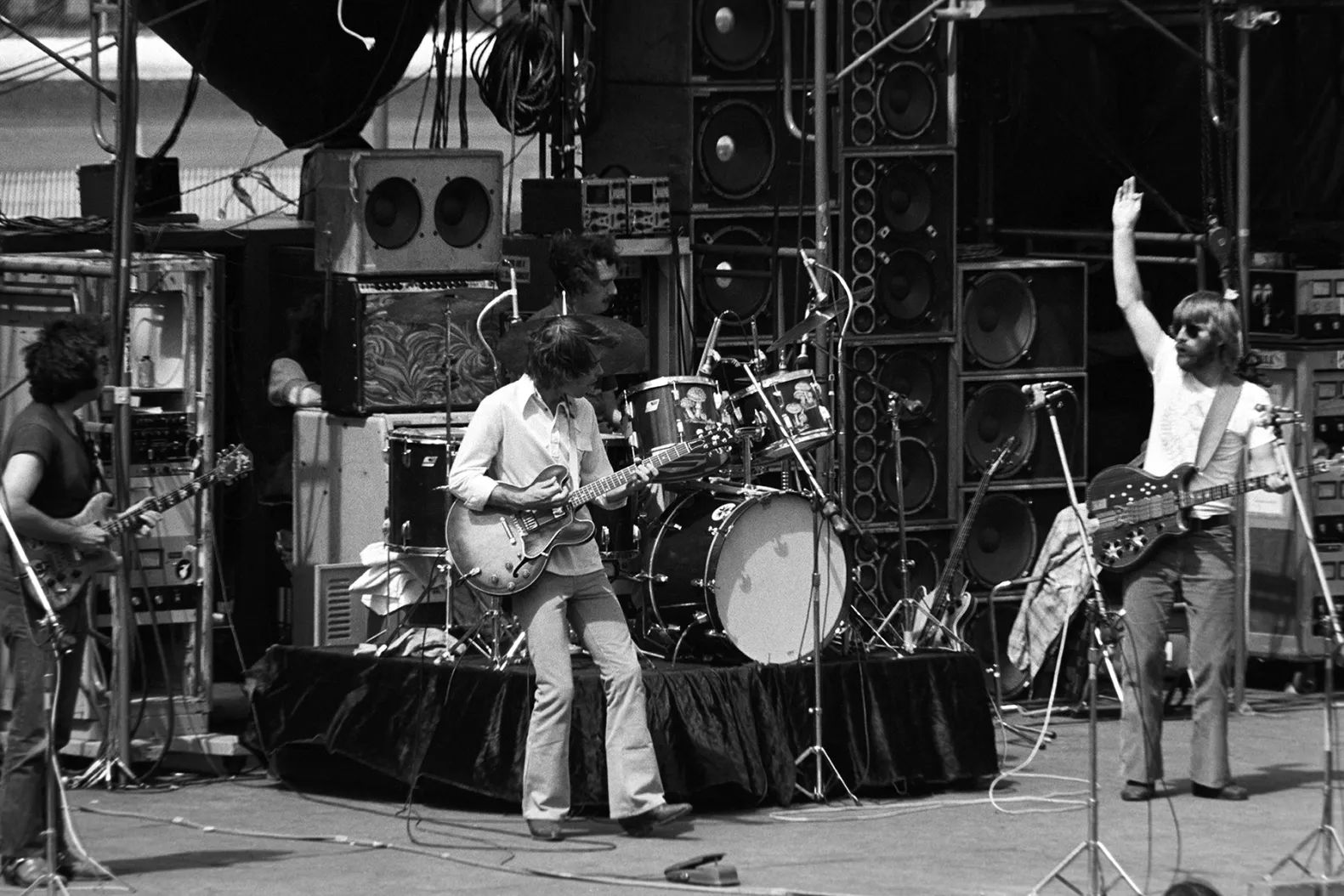

Grateful Dead durante su gira de 1974. Se puede ver parte de la configuración de su Wall of Sound detrás del grupo

La década de los setenta fue el territorio de la experimentación sin red. El sonido en vivo todavía no era una disciplina consolidada, sino un campo de ensayo en el que cada gira servía como prototipo. Los ingenieros y las bandas aprendían a la vez, y cada intento fallido se convertía en un paso hacia la profesionalización. El ideal era sencillo de formular y casi imposible de cumplir: volumen, claridad y estabilidad en espacios cada vez más grandes.

El ejemplo más extremo fue el Wall of Sound de los Grateful Dead en 1974. Diseñado por Owsley “Bear” Stanley, combinaba 48 amplificadores McIntosh MC2300 con decenas de columnas de altavoces JBL y Electrovoice. El sistema generaba más de 26.000 vatios y proyectaba el sonido hasta 180 metros con una pureza inédita. Cada instrumento tenía su propio canal y su propia configuracón de altavoces, eliminando la necesidad de mezcla tradicional. La idea era que el público escuchara exactamente lo mismo que los músicos en el escenario.

El Wall of Sound representó tanto el cénit como el límite de esa filosofía. Su despliegue requería varios camiones, un equipo técnico descomunal y un presupuesto insostenible. Se desmontó tras pocos meses. Pero su impacto fue duradero: demostró que la escala no era enemiga de la calidad y que la búsqueda del sonido perfecto era una cuestión de ingeniería, no de magia.

Mientras tanto, Bill Hanley continuó refinando la idea de control sonoro con los primeros monitores de escenario. Aquellos altavoces en forma de cuña permitieron que los músicos se escucharan por primera vez sin depender del rebote del público o del eco de los recintos. Esa innovación, menor en apariencia, cambió por completo la forma de tocar en directo. La comunicación sobre el escenario se volvió posible y, con ella, la precisión interpretativa. Y digo esto como músico: escucharse en directo es una de las mayores bendiciones de la ingeniería moderna.

También en esta década surgió el concepto de Front of House (FOH), la posición central donde el ingeniero mezcla desde el punto de escucha del público. Hasta entonces, el sonido se controlaba desde un lateral o incluso desde detrás del escenario. El cambio fue estructural: permitió decisiones basadas en percepción real y no en conjeturas acústicas. La figura del ingeniero de sonido comenzó a profesionalizarse.

Hacia finales de los setenta, la industria había entendido que la amplificación masiva era una ciencia en evolución. Los altavoces de bocina seguían dominando, pero la obsesión ya no era solo alcanzar mayor volumen, sino obtener control. Cada avance —del monitor en cuña al FOH— respondía a una misma intuición: el sonido debía dejar de ser impredecible. Lo que en Woodstock era supervivencia, en los setenta empezaba a ser ingeniería.

Años 80: Profesionalización y estandarización

Dos altavoces de la serie Cabaret de JBL. Estos fueron de lo primeros en colocarse en voladizo

Los años ochenta sirvieron para dejar claro que el sonido en vivo tenía sus propias normas. Las giras dejaron de ser aventuras experimentales para convertirse en operaciones técnicas con planificación logística, protocolos de montaje y equipos dedicados a cada función. La figura del ingeniero de sonido pasó de ser un colaborador marginal a un especialista indispensable. Las grandes compañías empezaron a fabricar sistemas modulares estandarizados y se estableció una relación más directa entre fabricantes, artistas y empresas de alquiler.

La clave de la década fue la portabilidad. Los sistemas pasaron de ser estructuras hechas a medida a productos comerciales con componentes intercambiables. JBL introdujo su serie Cabaret en 1980: gabinetes portátiles de dos vías con woofers de 12 o 15 pulgadas y motores de compresión de titanio. Por primera vez, un mismo sistema servía tanto para un club como para un festival, y esa flexibilidad lo convirtió en un estándar. Muchos locales adoptaron aquellos equipos de gira como instalación permanente.

Paralelamente, la práctica de volar los altavoces —suspenderlos sobre el público— se generalizó. Hasta entonces, los sistemas se apilaban sobre el suelo, lo que limitaba la cobertura y generaba zonas muertas. Al elevar los gabinetes y orientarlos , los ingenieros lograron una dispersión más homogénea. Fue el paso previo a los line arrays modernos, aunque aún sin la tecnología de predicción que llegaría más tarde.

La adopción de gabinetes trapezoidales facilitó este cambio. Su diseño permitía acoplar varias unidades con ángulos controlados, creando columnas de sonido con menos interferencias. Este avance, junto con los nuevos materiales ligeros y resistentes, redujo tiempos de montaje y riesgos estructurales. Por primera vez, el rendimiento acústico empezó a depender tanto de la física como de la geometría.

A finales de la década, el sonido en directo ya no era una extensión del estudio, sino un medio independiente. JBL y otros fabricantes competían por ofrecer mayor presión sonora, menor peso y mejor control de dispersión. Los festivales crecían, las giras se globalizaban y la profesionalización era total. El escenario dejaba de ser un experimento para convertirse en una plataforma de ingeniería aplicada al entretenimiento masivo.

Años 90: La revolución del line array

L Acoustics K3, una de las soluciones para sonido directo más populares

La década de los noventa transformó para siempre la forma de amplificar música en directo. Hasta entonces, el sonido se distribuía mediante fuentes puntuales: torres independientes que irradiaban en todas direcciones y se solapaban entre sí. El resultado era un mar de interferencias y cancelaciones que obligaba a los ingenieros a sacrificar claridad por volumen. El cambio llegó desde Francia, cuando el físico Christian Heil, fundador de L-Acoustics, aplicó principios de interferencia constructiva para desarrollar el line array moderno.

El sistema V-DOSC, presentado a principios de los noventa, organizaba los altavoces en columnas verticales donde cada elemento cooperaba acústicamente con el siguiente. En lugar de emitir ondas esféricas que se dispersan rápidamente, generaban ondas cilíndricas capaces de mantener la energía a mayor distancia y con menos degradación. La cobertura era más uniforme, la inteligibilidad aumentaba y, por primera vez, la experiencia sonora se volvía predecible en recintos abiertos.

La aparición del line array marcó un punto de inflexión. De pronto, el sonido podía diseñarse matemáticamente antes del montaje. Los softwares de predicción empezaron a reemplazar el ensayo y error, y la mezcla se convertía en una extensión de la arquitectura. Para los festivales masivos, aquello significó la diferencia entre el caos sonoro de Woodstock y la nitidez quirúrgica de los escenarios contemporáneos.

JBL no tardó en responder. Aunque ya en 1975 había experimentado con el modelo 4682 “Strongbox”, fue en esta década cuando formalizó su propio enfoque con el sistema HLA (High-Level Array). Ese diseño sentó las bases del futuro VerTec, que llegaría en el año 2000. Durante esos años, el fabricante luchó para dejar claro que debía contarse con él en entornos profesionales y empezó a colaborar con ingenieros de sonido de gran formato. La ingeniería de conciertos se había convertido en una ciencia aplicada, y JBL formaba parte del frente experimental.

La revolución tecnológica coincidió con una nueva cultura del espectáculo. Los festivales dejaron de ser eventos marginales y se convirtieron en plataformas mediáticas globales. Las marcas de audio comenzaron a mostrar sus sistemas en demostraciones internacionales, y ya lo vimos en el AudioLab de Kvistgård: el mensaje era claro, la gran diferencia ya no estaba en “sonar más fuerte”, sino en “sonar controlado” en cualquier punto del recinto. La profesionalización alcanzaba incluso la forma en que se enseñaba a escuchar.

Esa misma lógica se extendió a los entornos urbanos. Aquella muestra condensaba el salto conceptual de la época: la tecnología de festivales empezaba a filtrarse hacia el consumo cotidiano. Los line arrays habían dejado de ser herramientas de ingeniería para convertirse en el nuevo estándar del sonido contemporáneo.

Años 2000–2010: La era de los megaeventos

Sistema Milo de Meyer Sound, muy en boga durante la primera década del siglo XXI

La entrada en los dos mil trajo un cambio de escala y de mentalidad. Los conciertos dejaron de medirse en vatios o asistentes para hacerlo en cobertura y control. Los festivales y giras internacionales ya no dependían de soluciones improvisadas: cada sistema debía ser replicable, predecible y seguro. La ingeniería de sonido en directo se convirtió en una disciplina industrial, con software de simulación, protocolos de red y diseños modulares capaces de adaptarse a cualquier recinto. A día de hoy, un técnico de estudio y uno de directo son primos, pero no hermanos.

El avance decisivo vino de la mano de la digitalización. El procesamiento de señal dejó de ser analógico y pasó a estar informatizado, lo que permitió aplicar correcciones precisas en tiempo real. Las consolas digitales reemplazaron a las mesas tradicionales, y los sistemas de predicción acústica empezaron a definir la ubicación exacta de cada altavoz antes del montaje. La mezcla ya no era un acto de intuición: era una operación de modelado acústico en tres dimensiones.

En ese ecosistema surgieron estándares que dominaron la década: VerTec de JBL, Meyer MILO, V-DOSC de L-Acoustics o d&b J-Series. Más que competir, representaban una convergencia tecnológica: line arrays de gran formato con control DSP integrado y herramientas de predicción coherentes. En el caso del VerTec, su adopción en eventos como la Super Bowl o los Grammy demostró que los grandes espectáculos requerían un control acústico antes impensable, pero su relevancia residía en simbolizar esa nueva forma de pensar el sonido como arquitectura.

La consecuencia inmediata fue el salto del sonido a la planificación global del evento. Los ingenieros empezaron a trabajar junto a diseñadores de iluminación y producción escénica desde la fase inicial. El audio dejó de ser un bloque independiente para integrarse en un ecosistema audiovisual completo, conectado por redes digitales y sincronizado con sistemas de tiempo y control centralizados.

Esa década definió el modelo que seguimos viendo hoy: sonido escalable, predecible y controlado. Los festivales dejaron de ser espacios “que suenan bien” para convertirse en entornos diseñados acústicamente. Lo que comenzó en los setenta como una búsqueda empírica encontró, por fin, su lenguaje formal. El sonido en vivo se había convertido en ingeniería de sistemas.

2010–presente: la era del audio inmersivo

El protocolo Dante y las redes distribuidas han supuesto un enorme cambio para el sonido directo en la era actual

Durante la década de 2010, la digitalización se dio por completada y el foco pasó al control. Con la potencia y la fiabilidad ya resueltas, el interés se centró en la experiencia auditiva como espacio tridimensional. Los festivales y giras empezaron a funcionar con la lógica de un sistema cerrado: cada variable medida, cada ajuste previsto. La mezcla se convirtió en una forma de cartografía.

Los line arrays se refinaron en tamaño, peso y respuesta. Se incorporaron subwoofers en configuración cardioide para contener las bajas frecuencias en dirección al público y evitar rebotes indeseados sobre el escenario. Los programas de predicción empezaron a integrar factores ambientales —viento, humedad, temperatura— y los procesadores DSP aplicaban correcciones automáticas sin intervención humana. La ingeniería del directo pasó de la reacción a la planificación.

Festivales como Coachella o Tomorrowland reflejan ese cambio. En lugar de apilar torres, se diseñan redes completas de altavoces con señal digital distribuida por protocolos Dante o AVB. Cada torre de retardo se alinea en fase y tiempo con el sistema principal. La diferencia respecto a décadas anteriores no está en la potencia, sino en la homogeneidad: el público ya no se mueve entre zonas buenas y malas, sino dentro de un mismo campo sonoro.

Sistemas como el VTX de JBL —junto con los de Meyer, L-Acoustics o d&b— forman parte de esta etapa. Integran procesamiento interno, herramientas de predicción y estructuras de montaje más eficientes. De hecho, en el JBL Club London pudimos escuchar en acción el sistema VTX en un contexto más cercano al público. En giras internacionales y festivales medianos, estos sistemas permiten desplegar configuraciones complejas con equipos técnicos más reducidos y resultados consistentes.

A partir de ahí, el audio inmersivo empezó a extenderse como idea general. El formato Dolby Atmos Live o los arrays suspendidos sobre el público buscan que el sonido no se perciba desde un punto concreto, sino desde el entorno. Algunos escenarios experimentan con suelos equipados con transductores táctiles o sistemas multicanal en forma de cúpula. Se trata de una exploración técnica más que de una tendencia estética: aprovechar el espacio como parte del instrumento.

El sonido en directo, tal como se entiende hoy, es una práctica de control y equilibrio. Lo que en Woodstock era un intento de supervivencia técnica, ahora es una disciplina precisa y silenciosa. La pregunta ya no es cómo sonar más fuerte, sino cómo distribuir el sonido sin perder su forma.

El futuro: tendencias emergentes

Dolby Atmos también se está colando en los eventos en directo

El desarrollo actual apunta hacia sistemas cada vez más adaptativos. Los fabricantes trabajan en algoritmos capaces de ajustar la ecualización y la dispersión en tiempo real según los cambios del entorno o del público. La inteligencia artificial empieza a intervenir en tareas de calibración, sustituyendo parte del trabajo manual de los técnicos. En paralelo, los equipos se vuelven más ligeros, modulares y energéticamente eficientes, lo que reduce el impacto logístico de los grandes montajes.

La otra línea de avance es la espacialización. Los sistemas basados en objetos —como Dolby Atmos o L-ISA— ya se utilizan en giras de alto presupuesto, y es probable que su adopción se extienda a recintos medianos en los próximos años. Esto implica un cambio de mentalidad: la mezcla deja de pensarse como estéreo o frontal y pasa a ocupar el volumen completo del espacio. Los conciertos se diseñan con la misma lógica que una instalación sonora.

También crece la intersección entre lo físico y lo virtual. La realidad aumentada y la transmisión inmersiva por streaming buscan extender la experiencia de los festivales más allá del recinto. Algunos eventos experimentan con audio binaural en directo o con sensores que traducen el movimiento del público en parámetros de mezcla. El límite entre escenario y audiencia se vuelve difuso, y el sonido actúa como interfaz común.

Nada de esto sustituye a la experiencia colectiva, pero sí la redefine. El futuro del sonido en vivo parece menos interesado en la espectacularidad y más en la precisión perceptiva: menos vatios, más control. Lo que comenzó como una necesidad técnica —hacer que algo se oyera— ha derivado en un ejercicio de diseño perceptivo, donde cada innovación busca la misma meta que en 1969: que la multitud escuche, y que cada uno sienta que está en el centro.